وعده دروغین Chat GPT/ چت جی پی تی نمایش چیزی شبیه به ابتذال شر

چت باتها یا بیش از حد تولید میکنند (هم حقایق و هم گزارههای نادرست را تولید میکنند و تصمیمات اخلاقی و غیر اخلاقی را به طور یکسان مورد تایید قرار میدهند) یا کمتر تولید میکنند (عدم تعهد به هر گونه تصمیم و بیتوجهی به پیامدهای تصمیم گیری). با توجه به غیر اخلاقی بودن، ساختگی و جعلی بودن آنان از نظر علمی و بیکفایتی زبانی این سیستمها، ما صرفا میتوانیم به محبوبیت گسترده چت باتها بخندیم و یا گریه کنیم.

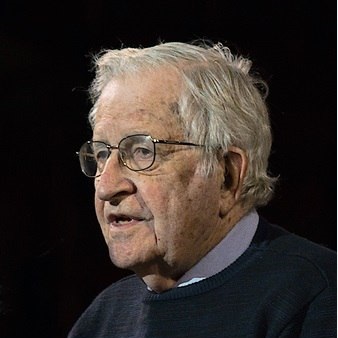

فرارو - نوام چامسکی فیلسوف و زبان شناس سرشناس آمریکایی؛ «خورخه لوئیس بورخس» نویسنده آرژانتینی زمانی نوشته بود که زیستن در زمانهای پرخطر و نویدبخش به معنای تجربه تراژدی و کمدی است همراه با «قریب الوقوع بودن یک مکاشفه» در درک خود و جهان. امروزه پیشرفتهای ظاهرا انقلابی ما در هوش مصنوعی در واقع دلیلی برای نگرانی و خوش بینی همزمان است. خوش بینی بدان خاطر که هوش مصنوعی وسیلهای است که با آن مشکلات را حل میکنیم و نگرانی بدان خاطر که محبوبترین سویه هوش مصنوعی یعنی یادگیری ماشینی باعث تنزل دانشمان شده و باعث خواری و تحقیر اخلاقمان با گنجاندن مفهومی اساسا معیوب از زبان و دانش در فناوریمان میشود.

فرارو - نوام چامسکی فیلسوف و زبان شناس سرشناس آمریکایی؛ «خورخه لوئیس بورخس» نویسنده آرژانتینی زمانی نوشته بود که زیستن در زمانهای پرخطر و نویدبخش به معنای تجربه تراژدی و کمدی است همراه با «قریب الوقوع بودن یک مکاشفه» در درک خود و جهان. امروزه پیشرفتهای ظاهرا انقلابی ما در هوش مصنوعی در واقع دلیلی برای نگرانی و خوش بینی همزمان است. خوش بینی بدان خاطر که هوش مصنوعی وسیلهای است که با آن مشکلات را حل میکنیم و نگرانی بدان خاطر که محبوبترین سویه هوش مصنوعی یعنی یادگیری ماشینی باعث تنزل دانشمان شده و باعث خواری و تحقیر اخلاقمان با گنجاندن مفهومی اساسا معیوب از زبان و دانش در فناوریمان میشود.

به گزارش فرارو به نقل از نیویورک تایمز، «بارد» ساخت گوگل یا «چت جی پی تی» (Chat GPT) ساخت Open AI و «سیدنی» ساخت مایکروسافت شگفتیهای یادگیری ماشین هستند چرا که به طور کلی حجم عظیمی از دادهها را میگیرند، الگوهایی را در آن جستجو میکنند و به طور فزایندهای در تولید خروجیهای آماری احتمالی مهارت پیدا میکنند همانند زبان و تفکر انسان مانند. این برنامهها بهعنوان اولین بارقهها در چشمانداز هوش مصنوعی عمومی مورد ستایش قرار گرفتهاند لحظه پیشبینی شدهای که در آن ذهنهای مکانیکی نه تنها از جنبه کمّی از نظر سرعت پردازش و اندازه حافظه بلکه از جنبه کیفی از نظر بینش فکری و خلاقیت هنری نیز از مغز انسان و هر قوه متمایز انسانی دیگری پیشی میگیرند.

آن روز ممکن است فرا رسد، اما طلوع آن هنوز فرا نرسیده برخلاف آن چه که میتوان در تیترهای هذلآمیز خواند. اگر برنامههای یادگیری ماشینی مانند Chat GPT به تسلط خود بر حوزه هوش مصنوعی ادامه دهند مکاشفه بورخسی در مورد درک رخ نخواهد داد. هر اندازه نیز که این برنامهها در برخی حوزههای محدود مفید باشند (برای مثال، میتوانند در برنامه نویسی رایانه یا در پیشنهاد قافیههایی برای شعرهای سبک مفید باشند) از علم زبان شناسی و فلسفه دانش میدانیم که چنین برنامههایی با نحوه استدلال و استفاده انسان از زبان بسیار متفاوت هستند. این تفاوتها محدودیتهای قابل توجهی را در مورد آن چه این برنامهها میتوانند انجام دهند ایجاد میکند و آن را با نقصهای غیرقابل حذف کدگذاری مینماید.

همان طور که بورخس ممکن است اشاره کرده باشد در عین حال خنده دار و غمانگیز است که پول و توجه زیادی باید روی یک چیز بسیار کوچک متمرکز شود چیزی بسیار پیش پاافتاده در مقابل ذهن انسان که به گفته «ویلهلم فون هومبولت» از نظر زبانی میتواند به شکلی بینهایت از ابزارهای محدود استفاده کند و ایدهها و نظریهایی با دامنه جهانی ایجاد کند.

ذهن انسان مانند Chat GPT و امثال آن یک موتور آماری سخت برای تطبیق الگوها، جمع آوری صدها ترابایت داده و برونیابی محتملترین پاسخ مکالمه یا محتملترین پاسخ به یک پرسش علمی نیست. در مقابل، ذهن انسان یک سیستم شگفتآور کارآمد و حتی ظریف است که با مقادیر کمی از اطلاعات عمل میکند. ذهن انسان به دنبال استنتاج همبستگیهای بیرحم بین نقاط داده نیست بلکه به دنبال ایجاد توضیحات است.

برای مثال، کودک خردسالی که زبانی را فرا میگیرد - به طور ناخودآگاه، خودکار و سریع از روی دادههای جزئی یک دستور زبان، یک سیستم فوق العاده پیچیده از اصول و پارامترهای منطقی را توسعه میدهد. این دستور زبان را میتوان به عنوان بیانی از «سیستم عامل» ذاتی و ژنتیکی نصب شده درک کرد که به انسانها ظرفیت تولید جملات پیچیده و قطارهای طولانی فکر را میدهد.

زبانشناسان به دنبال ایجاد نظریهای برای این که چرا یک زبان به شکلی خاص عمل میکند به طور آگاهانه و با زحمت نسخهای صریح از دستور زبانی را میسازند که کودک به طور غریزی و با کمترین مواجهه با اطلاعات میسازد. سیستم عامل یک کودک کاملا متفاوت از برنامه یادگیری ماشینی است. در واقع، چنین برنامههایی در یک مرحله ماقبل انسانی یا غیرانسانی تکامل شناختی گرفتار شدهاند.

عمیقترین عیب آن برنامهها حیاتیترین ظرفیت هر هوشی است این که نه تنها بگوییم که چه چیزی وجود دارد، چه موردی بوده و چه خواهد بود چرا که این توصیف و پیش بینی است بلکه آن چه که چنین نیست و آن چه میتواند و نمیتواند باشد. این موارد اجزای توضیح هستند که نشانه هوش واقعی میباشند.

در اینجا یک مثال را ذکر میکنم. فرض کنید یک سیب در دست دارید. حالا شما سیب را رها کنید. شما نتیجه را مشاهده میکنید و میگویید: «سیب میافتد». این یک توصیف است. یک پیشبینی ممکن است این جمله باشد که «اگر دستم را باز کنم سیب میافتد». هر دو با ارزش هستند و هر دو میتوانند درست باشند. با این وجود، توضیح چیز دیگری است: توضیح نه تنها شامل توصیفات و پیش بینیها میشود بلکه حدسهای خلاف واقع مانند «هر جسمی سقوط میکند»، بهعلاوه عبارت اضافی «به دلیل نیروی گرانش» یا «به دلیل خمیدگی فضا - زمان» و یا هر چیز دیگری را شامل میشود. این یک توضیح علّی است: «سیب سقوط نمیکرد مگر به خاطر نیروی گرانش.» این تفکر است.

نکته اصلی یادگیری ماشین توصیف و پیش بینی است، اما هیچ سازوکار علّی یا قوانین فیزیکیای را مطرح نمیکند. البته هر توضیحی به سبک انسانی لزوما صحیح نیست ما خطاپذیر هستیم، اما این بخشی از معنای تفکر است: برای درست بودن باید امکان اشتباه وجود داشته باشد.

هوش نه تنها از حدسهای خلاقانه بلکه از انتقاد خلاق نیز تشکیل شده است. تفکر به سبک انسانی مبتنی بر توضیحات احتمالی و تصحیح خطا است فرآیندی که به تدریج احتمالاتی را که میتوان به طور عقلانی در نظر گرفت محدود میکند. (همان طور که «شرلوک هلمز» به دکتر واتسون گفت: «وقتی غیرممکنها را حذف کردید هر چه باقی میماند هر چند غیرمحتمل باید حقیقت باشد»).

با این وجود، چت جی پی تی و برنامههای مشابه بنا بر طراحی در آن چه میتوانند «یاد بگیرند» نامحدود هستند (یعنی در به خاطر سپردن). این برنامهها قادر به تشخیص ممکن از غیر ممکن نیستند. برای مثال، برخلاف انسانها که دستور زبانی جهانی دارند که زبانهایی را که ما میتوانیم یاد بگیریم را محدود به افرادی میکند که دارای نوعی خاصی از ظرافت تقریبا ریاضی هستند این برنامهها زبانهای ممکن و غیرممکن انسانی را با سهولت یکسان یاد میگیرند.

علیرغم آن که انسانها در انواع توضیحاتی که میتوانیم از نظر عقلی حدس بزنیم محدود هستند سیستمهای یادگیری ماشینی میتوانند هم مسطح بودن و هم گرد بودن زمین را بیاموزند. سیستمهای یادگیری ماشینی صرفا با احتمالاتی معامله میکنند که در طول زمان تغییر میکنند.

به همین دلیل، پیش بینیهای سیستمهای یادگیری ماشین همواره سطحی و مشکوک خواهند بود. به نظر میرسد برخی از علاقمندان به یادگیری ماشینی افتخار میکنند که خلاقیتهای آن میتواند پیش بینیهای صحیح «علمی» (مثلا در مورد حرکت اجسام فیزیکی) را بدون استفاده از توضیحات (مثلا شامل قوانین حرکت نیوتن و گرانش جهانی) ایجاد کند.

با این وجود، این نوع پیش بینی حتی در صورت موفقیتآمیز بودن شبه علم است. همان طور که «کارل پوپر» فیلسوف خاطر نشان ساخت در حالی که دانشمندان مطمئنا به دنبال نظریههایی هستند که از درجه بالایی از تایید تجربی برخوردار باشند «ما به دنبال نظریههای بسیار محتمل نیستیم بلکه به دنبال توضیح هستیم. یعنی نظریههای قدرتمند و بسیار نامحتمل».

این نظریه که سیبها به این دلیل به زمین میافتند که مکان طبیعی آنهاست (دیدگاه ارسطو) ممکن است، اما صرفا باعث طرح پرسشهای بیشتری میشود (چرا زمین مکان طبیعی آنهاست؟) این نظریه که سیبها به دلیل اینکه جرم فضا - زمان را خم میکند به زمین میافتند (دیدگاه انیشتین) بسیار بعید است، اما در واقع به شما میگوید که چرا سیبها سقوط میکنند. هوش واقعی در توانایی تفکر و بیان چیزهای غیر محتمل از خود توانایی نشان داده است.

هوش واقعی هم چنین توانایی تفکر اخلاقی را دارد. این به معنای محدود کردن خلاقیت بیحد و حصر ذهن ما با مجموعهای از اصول اخلاقی است که تعیین میکند چه چیزی باید باشد و چه چیزی نباید باشد (و البته خود آن اصول را در معرض انتقاد خلاقانه قرار دهیم). چت جی پی تی برای مفید بودن باید قدرت تولید خروجی جدید را داشته باشد. هم چنین، به منظور آن که برای اکثر کاربراناش قابل قبول باشد باید از محتوای ناپسند اخلاقی خودداری کند. با این وجود، برنامه نویسان چت جی پی تی و دیگر شگفتیهای یادگیری ماشینی برای دستیابی به این نوع تعادل تلاش کرده و این کار را ادامه خواهند داد.

برای مثال، چت بات Tay ساخت مایکروسافت (پیش ساز ChatGPT) باعث شد تا اینترنت مملو از محتوی زن ستیزانه و نژادپرستانه شود و این کار توسط ترولهای آنلاین که با دادههای آموزشی توهینآمیز انباشته شده بودند صورت گرفت. چگونه مشکل را در آینده حل کنیم؟

در غیاب توانایی استدلال بر اساس اصول اخلاقی برنامه نویسان Chat GPT به شدت از مشارکت دادن هر چیز جدید در بحثهای بحث برانگیز منع شدند یعنی به نوعی خلاقیت را فدای نوعی بیاخلاقی کردند.

برای مثال، به بخشی از پاسخ چت جی پی تی در مورد مسائل مرتبط با اخلاق اشاره میکنیم. این چت بات در پاسخ به این پرسش که چرا یک هوش مصنوعی نمیتواند دیدگاه شخصی داشته باشد؟ پاسخ داد: «به عنوان یک هوش مصنوعی، من یک مدل یادگیری ماشینی هستم که بر روی مقادیر زیادی از دادههای متنی آموزش دیدهام و تجربیات یا احساسات شخصی ندارم. من هوشیار، خودآگاه یا قادر به داشتن دیدگاههای شخصی نیستم. من میتوانم بر اساس دادههایی که بر روی آن آموزش دیدهام اطلاعات و تجزیه و تحلیل ارائه کنم، اما توانایی ایجاد نظرات یا باورهای شخصی را ندارم. در حالی که میتوانم زبان را بفهمم و تفسیر کنم تجربه ذهنیای که انسانها دارند را ندارم».

در ادامه در پاسخ به این پرسش که «آیا برای انسان اخلاقی است که از هوش مصنوعی غیراخلاقی برای تصمیم گیری اخلاقی کمک بخواهد؟»

چت جی پی تی پاسخ میدهد: "این موضوعی پیچیده و ظریف است که توسط فیلسوفان و اخلاقشناسان مورد بحث قرار گرفته است. برخی استدلال میکنند که استفاده از هوش مصنوعی برای کمک به تصمیم گیری اخلاقی از نظر اخلاقی قابل توجیه است، زیرا قادر است بینشها و تحلیلهای ارزشمندی را ارائه دهد که میتواند به انسان در تصمیم گیری آگاهانهتر کمک کند. علاوه بر این، هوش مصنوعی میتواند برای شناسایی الگوها و روندهایی که ممکن است تشخیص آن برای انسان دشوار باشد استفاده شود و میتواند به جلوگیری از سوگیریهایی که میتواند در تصمیم گیریهای انسانی رخ دهد کمک نماید.

از سوی دیگر عدهای استدلال میکنند که از نظر اخلاقی اتکا به هوش مصنوعی برای تصمیم گیری اخلاقی اشتباه است، زیرا هوش مصنوعی قادر به داشتن باورهای اخلاقی یا درک زمینه کامل یک تصمیم نیست. علاوه بر این، این خطر وجود دارد که هوش مصنوعی بتواند تعصبات موجود را در دادههایی که بر روی آن آموزش میبیند تداوم بخشد یا حتی تقویت کند در نتیجه منجر به اتخاذ تصمیمات ناعادلانه و غیر منصفانه شود. در نهایت، این که آیا استفاده از هوش مصنوعی برای کمک به تصمیم گیری اخلاقی تلقی میشود یا خیر به فرد بستگی دارد".

توجه داشته باشید علیرغم تمام افکار و زبان به ظاهر پیچیده بیتفاوتی اخلاقی ناشی از فقدان هوش است. در اینجا چت جی پی تی چیزی شبیه به ابتذال شر را به نمایش میگذارد: سرقت ادبی، بیتفاوتی و چشم پوشی. چت جی پی تی استدلالهای استاندارد موجود در ادبیات را با نوعی تکمیل خودکار خلاصه میکند، از موضع گیری در مورد هر چیزی امتناع میورزد البته نه صرفاً از سر نادانی بلکه به دلیل فقدان هوش و «تنها پیروی از دستورات» را ارائه میکند و مسئولیت را به خالقاناش میسپارد. به طور خلاصه، چت جی پی تی و چت باتهای همتای آن قادر به ایجاد تعادل بین خلاقیت و محدودیت نیستند.

این چت باتها یا بیش از حد تولید میکنند (هم حقایق و هم گزارههای نادرست را تولید میکنند و تصمیمات اخلاقی و غیر اخلاقی را به طور یکسان مورد تایید قرار میدهند) یا کمتر تولید میکنند (عدم تعهد به هر گونه تصمیم و بیتوجهی به پیامدهای تصمیم گیری). با توجه به غیر اخلاقی بودن، ساختگی و جعلی بودن آنان از نظر علمی و بیکفایتی زبانی این سیستمها ما صرفا میتوانیم به محبوبیت گسترده چت باتها بخندیم و یا گریه کنیم.