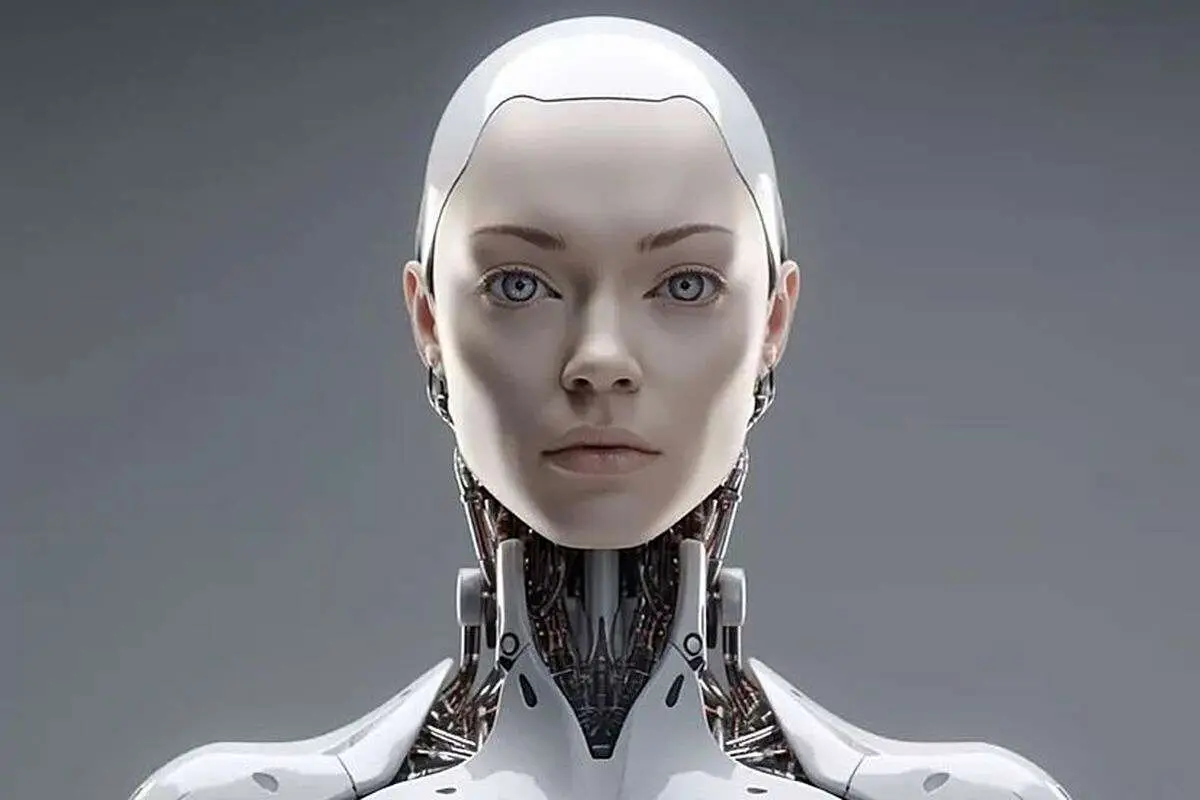

آیا باید نگران هوش مصنوعی باشیم؟

فناوری هوش مصنوعی، خطرات جدیدی را ایجاد میکند، اما فرصتهای خارق العادهای را هم به دنبال خواهد داشت. متعادل کردن این دو به معنای گام برداشتن با دقت است.

سرعت رشد هوش مصنوعی هم هیجان انگیز است هم ترسناک. در ماههای اخیر با در دسترس قرار گرفتن هوش مصنوعی «Chatgpt» توسط شرکت استارت آپی OpenAI و برخی سامانههایی که با استفاده از هوش مصنوعی تصویر سازی میکنند، مقالات زیادی درباره از بین رفتن مشاغل در صورت تقویت هوش مصنوعی منتشر شده است. اما سوال اینجاست که چقدر این نگرانی واقعی است؟

به گزارش رویداد ۲۴، «آیا هوش مصنوعی و رباتها یک روز جایگزین انسان خواهند شد؟ آیا با توسعه هوش مصنوعی با خطر از دست دادن کنترل تمدن زمین روبرو خواهیم شد؟» این سؤالات سالهاست در ذهن انسان میگذرد و سینما بارها چنین آیندهای را برای بشر ترسیم کرده است.

ماه گذشته همین سوالات در قالب نامهای سرگشاده به امضای رجال حوزه تکنولوژی از جمله ایلان ماسک از مؤسسه «آینده زندگی» پرسیده شد. این موسسه غیرانتفاعی آمریکایی سازمانی است که با هدف کاهش خطرات و فجایعی که متوجه انسانهاست فعالیت میکند. یکی از مهمترین خطراتی که این موسسه شناسایی کرده، خطر پیشرفت هوش مصنوعی است. امضاکنندگان نامه سرگشاده خواستار یک «مکث» شش ماهه در ایجاد شکلهای پیشرفته هوش مصنوعی (AI) شدند تا در مورد خطرات بالقوه این فناوری تحقیقات لازم انجام شود.

این نگرانیها به طور ویژه بعد از در دسترس قرار گرفتن ChatGBT شدت گرفت. تواناییهای این ربات که توسط شرکت OpenAI طراحی شده، حتی سازندگانش را غافلگیر کرده است. این ربات توانایی حل همه چیز از نوشتن کدهای رایانهای تا شناسایی فیلمها از خلاصه داستانهای نوشته شده با شکلکهای معروف به ایموجی را دارد.

آینده هوش مصنوعی

نشریه اکونومیست در گزارشی درباره نگرانیها از آینده انسان با هوش مصنوعی میگوید این مدلها میتوانند رابطه انسانها با رایانه، دانش و حتی با خودشان را تغییر دهند. طرفداران AI یا همان هوش مصنوعی بر پتانسیل آن برای حل مشکلات بزرگ، توسعه داروهای جدید، طراحی مواد جدید برای کمک به مبارزه با تغییرات آب و هوایی تاکید میکنند. از نظر دیگران، سناریوی پیشی گرفتن ماشینها از مخترعشان را جدی قلمداد میکنند.

این ترکیب هیجان و ترس، سنجش فرصتها و خطرات هوش مصنوعی را دشوار میکند. برای سنجش موقعیت باید از تجربه سایر صنایع و از تغییرات فناوری در گذشته درس گرفت. سوال این است که چه چیزی تغییر کرده که هوش مصنوعی را بسیار توانمندتر کرده است؟ چقدر باید ترسید؟ و دولتها چه باید بکنند؟

نشریه اکونومیست در پاسخ به این سوال میگوید موج اول سیستمهای هوش مصنوعی مدرن، که یک دهه پیش پدیدار شد، بر روی دادههای آموزشی با برچسبگذاری دقیق تکیه داشت. این سیستمها هنگامی که در معرض تعداد کافی نمونه برچسبگذاری شده قرار میگرفتند، میتوانستند کارهایی مانند تشخیص تصاویر یا رونویسی گفتار را بیاموزند. سیستمهای امروزی نیازی به برچسبگذاری اولیه ندارند و در نتیجه میتوان آنها را با استفاده از مجموعه دادههای بسیار بزرگتری که از منابع آنلاین گرفته شدهاند، آموزش داد.

این تواناییها زمانی که Chat GPT در ماه نوامبر منتشر شد، برای عموم مردم آشکار شد. یک میلیون نفر در عرض یک هفته از آن استفاده کردند. ۱۰۰ میلیون نفر در عرض دو ماه از آن برای نوشتن انشاهای مدرسه و سخنرانیهای عروسی استفاده کردند. استفاده از Chat GPT بعضا نتایج عجیبی هم به همراه داشت. بینگ چت متعلق به موتور جستجوگر ماکروسافت، به یک روزنامه نگار پیشنهاد کرد که همسرش را ترک کند. یک استاد حقوق Chat GPT به افترا متهم شد.

شتاب اخیر در قدرت و دید سیستمهای هوش مصنوعی و افزایش آگاهی از تواناییها و نقصهای آنها، این نگرانی را ایجاد کرده است که این فناوری که به سرعت در حال پیشرفت است به پدیدهای تبدیل شود که نتوانیم آن را کنترل کنیم. از این رو برخی افراد فراخوانی برای توقف فعالیت هوش مصنوعی دادند و نگرانی فزاینده درباره جایگزینی AI با بسیار از مشاغل، و حتی خطراتش برای موجودیت خود بشریت هم افزایش پیدا کرد.

اکونومیست در سرمقالهای که روی جلد مجله هفته گذشته هم منتشر شده از ترسی صحبت کرده قرنها با انسان بوده است؛ ترس از اینکه ماشینها مشاغل انسانی را بدزدند. اما اتفاقی که تا امروز افتاده این بوده که فناوریهای جدید، مشاغل جدیدی را ایجاد کردهاند که جایگزین مشاغلی شده که به خاطر این فناوریها نابود شده بودند. ماشینها برخی از وظایف را بر عهده میگیرند، نه همه آنها را و بنابراین تقاضا برای مشاغلی که ماشینها از پس آن بر نمیآیند افزایش پیدا میکند. اما سوال این جاست که آیا این بار ممکن است فرق داشته باشد؟

اکونومیست میگوید جابجایی ناگهانی در بازارهای کار را نمیتوان رد کرد، حتی اگر تا کنون هیچ نشانهای از آن وجود نداشته باشد. فناوریهای قبلی جایگزین مشاغلی میشدند که به نیروی ماهر نیازی نداشت، اما هوش مصنوعی میتواند برخی ازمشاغلی که قبلا به نیروهای ماهر تعلق داشت مانند خلاصه کردن اسناد یا کدنویسی را اشغال کند.

درجه خطر ناشی از رشد هوش مصنوعی به شدت مورد بحث است. کارشناسان بر سر این خطر اتفاق نظر ندارند. در یک نظرسنجی از محققان هوش مصنوعی که در سال ۲۰۲۲ انجام شد، ۴۸ گفتهاند که حداقل ۱۰ درصد احتمال دارد که هوش مصنوعی تاثیر «بسیار بد» (مثلاً انقراض انسان) را در پی داشته باشد. اما ۲۵ درصد گفتند که خطر بروز عواقب بسیار بد در صورت رشد هوش مصنوعی نزدیک به صفر است. تعدادی از محققان هم خطرات هوش مصنوعی را ۵ درصد اعلام کردند.

کابوس بزرگ این است که یک هوش مصنوعی پیشرفته با تولید نوعی سم یا ویروس یا ترغیب انسان به انجام اقدامات تروریستی باعث آسیب در مقیاس گسترده شود. لازم نیست این هوش مصنوعی الزاما قصد شیطانی داشته باشد: محققان نگرانند که شاید هوش مصنوعیهای آینده اهدافی داشته باشد که با اهداف خالقان انسانی آنها همسو نباشد.

اکونومیست تاکید دارد که چنین سناریوهایی را نباید نادیده گرفت. اما همه اینها مقدار زیادی حدس و گمان و انتظار جهشی جدی در فناوریهای امروزی است. بسیاری تصور میکنند که هوش مصنوعی در آینده دسترسی نامحدودی به انرژی، پول و قدرت محاسباتی خواهد داشت. دسترسی که امروزه با محدودیتهای جدی رو به روست. علاوه بر این، کارشناسان هر حوزه تمایل دارند درباره خطرات حوزه خود اغراق کنند. اعمال مقررات سنگین، یا درخواست یک مکث در توسعه هوش مصنوعی، واکنشی اغراق آمیز به نظر میرسد.

در واقع مقررات لازم است، اما به دلایل پیش پا افتادهتر از نجات بشریت. سیستمهای هوش مصنوعی موجود نگرانیهای واقعی را در مورد تعصب، حریم خصوصی و حقوق مالکیت معنوی ایجاد میکند. با پیشرفت فناوری، مشکلات دیگری نیز ممکن است به وجود بیاید. نکته کلیدی این است که وعدههای هوش مصنوعی باید با ارزیابی ریسکها به تعادل برسد و همه آماده همزیستی با آن باشند.

واکنش دولتها به رشد هوش مصنوعی چه بوده است؟

تاکنون دولتها سه رویکرد متفاوت را در مواجهه با هوش مصنوعی در پیش گرفتهاند. در انتهای این طیف بریتانیا قرار دارد که هیچ قوانین یا نهادهای نظارتی جدیدی برای هوش مصنوعی در نظر نگرفته، اما مقررات موجود را برای سیستمهای هوش مصنوعی هم اعمال میکند. هدف بریتانیا افزایش سرمایه گذاری و تبدیل کشور به یک «ابرقدرت هوش مصنوعی» است. آمریکا رویکرد مشابهی را در پیش گرفته، اگرچه دولت بایدن به دنبال کشف دیدگاههای عمومی در مورد قوانین احتمالی در آینده است.

اتحادیه اروپا موضع سختتری اتخاذ کرده است. قانون پیشنهادی آنها، استفادههای مختلف از هوش مصنوعی را بر اساس درجه خطر طبقهبندی میکند، و بر همین اساس نیازمند کشف درجه خطر انواع مختلف استفاده از هوش مصنوعی است. برخی از کاربردهای هوش مصنوعی از نظر اتحادیه اروپا به طور کلی ممنوع هستند، مانند پیامهای نیمه خودآگاه در تبلیغات و شناسایی چهره از راه دور. شرکتهایی که قوانین را زیر پا بگذارند جریمه خواهند شد.

اما برخی دیگر میگویند رویکرد سختگیرانهتری لازم است. دولتها باید با هوش مصنوعی مانند دارو رفتار کنند و یک ساز و کار شناسایی، آزمایشهای دقیق و تأیید اولیه قبل از انتشار عمومی داشته باشند. چین برخی از این کارها را انجام میدهد و شرکتها را ملزم میکند تا محصولات هوش مصنوعیشان را ثبت کنند و قبل از عرضه، بازبینی امنیتی را انجام میدهد. البته ایمنی در درجه دوم اهمیت بعد از سیاست قرار گرفته است. در چین یک شرط کلیدی این است که خروجی هوش مصنوعی باید منعکسکننده «ارزش اصلی سوسیالیسم» باشد.

با هوش مصنوعی چه باید کرد؟

اگر هوش مصنوعی به اندازه خودرو، هواپیما یا داروها یک فناوری مهم باشد (که دلایل خوبی برای این باور وجود دارد) پس مانند این فناوریها به قوانین جدیدی هم نیاز دارد. بر همین اساس، مدل اتحادیه اروپا بهترین مدل خواهد بود، اگرچه سیستم طبقهبندی آن بیش از حد پیچیده است، بنابراین رویکرد مبتنی بر یک سری اصول انعطافپذیرتر، بهتر خواهد بود. نحوه آموزش سیستمها، نحوه عملکرد و نحوه نظارت آنها و نیاز آنها به بازرسی باید به طرز قانع کنندهای افشا شود و سپس دولتها با قوانین مشابه سایر فناوریها به سراغ آن بروند.

در صورت نیاز، مقررات سختگیرانه تری هم در طول زمان ممکن است اعمال شود. همچنین ممکن است معاهدات بیندولتی، مشابه پیمانهایی که بر تسلیحات هستهای امضا میشوند، در صورتی که شواهد قابلقبولی مبنی بر خطرناک بودن یک هوش مصنوعی وجود داشته باشد، با هدف نظارت بر این خطرها ایجاد شود.

این فناوری قدرتمند، خطرات جدیدی را ایجاد میکند، اما فرصتهای خارق العادهای را هم به دنبال خواهد داشت. متعادل کردن این دو به معنای گام برداشتن با دقت است. یک رویکرد سنجیده در ابتدای مسیر میتواند زمینه اعمال قوانین بهتر و بیشتر در آینده را ایجاد کند. اما زمان شروع ساخت این زمینهها اکنون فرا رسیده است.